Коммутатор и Access Lists

Для фильтрации трафика коммутатор может использовать следующие типы ACL:

- Router ACL

- Port ACL

- VLAN ACL

- MAC ACL

Router ACL

Как и подразумевается в названии, Router ACL подобны на IOS ACL и используются для фильтрации сетевого трафика на SVI (интерфейсы SVI это Layer 3 на VLAN, физические Layer 3 интерфейсы и Layer 3 интерфейсы EtherChannel). Поддерживаются как стандартные, так и расширенные ACL. Для получения более детальной информации по Router ACL, обратитесь к соответствующей документации.

Port ACL

Port ACL подобны Router ACL, но работают на физических интерфейсах и интерфейсах Layer 2 коммутатора. Port ACL поддерживают фильтрацию только входящего трафика. Port ACL могут быть расширенного, стандартного и MAC-extended типа.

Обработка Port ACL подобна Router ACL: коммутатор проверяет ACL, назначенный данному интерфейсу и разрешает или блокирует пакет.

Когда ACL наложен на транковый порт, проверяется трафик всех проходящих через транк VLAN-ов — как данные, так и голос.

Основная прелесть Port ACL состоит в том, что может фильтроваться как IP трафик (используя IP access lists) так и non-IP трафик (используя MAC access list).

Внимание: Port ACLs не поддерживается на интерфейсах EtherChannel.

VLAN ACL (VACL)

VLAN ACL (так же известные как VLAN map) осуществляют пакетную фильтрацию всех типов трафика внутри VLAN или входящих/выходящих из него. В отличие от Router ACL, VACL не определяет направление трафика (input или output). Все пакеты находящиеся в VLAN (маршрутизируемые или внутренние) проверяются VACL. Для пакетной фильтрации в зависимости от направления трафика есть возможность использовать комбинацию VACL и Private VLAN.

VACL обрабатываются на аппаратном уровне, не оказывая влияния на производительность коммутатора. Производительность так же не зависит от объема VACL. Поэтому они упоминаются также как wire-speed ACL.

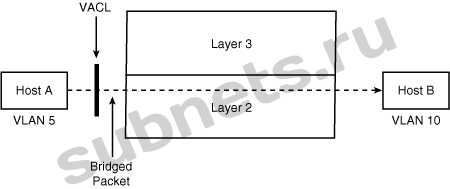

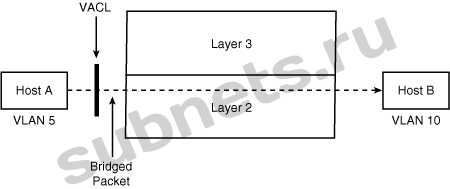

VACL на порту Layer 2

На рисунке ниже показана работа VACL на briged интерфейсе для Host A в VLAN 5 передающего данные на Host B в VLAN 10.

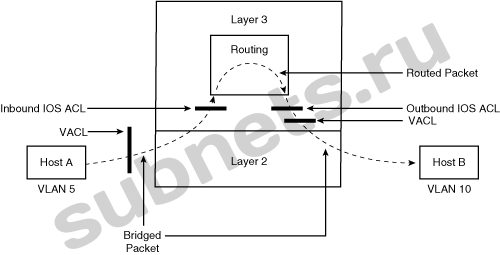

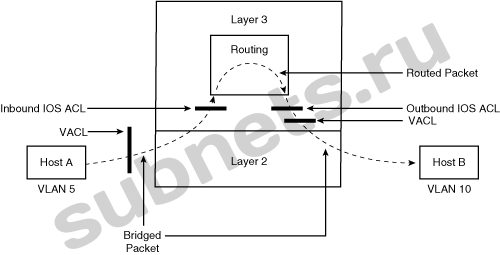

VACL маршрутизируемом порту

На рисунке ниже показана работа IOS ACL и VACL на маршрутизируемом интерфейсе. Порядок выполнения определяется следующим образом:

1. VACL для input VLAN

2. Input IOS ACL

3. Output IOS AC

4. VACL для output VLAN

Конфигурирование VACL

Для конфигурирования VACL (VLAN access map) необходимо выполнить следующие действия:

1. Определить стандартный или расширенный ACL, который будет использоваться на VACL.

2. Определить VLAN access map.

3. Описать критерий попадания

4. Описать выполняемое действие при попадании

5. Наложить VLAN access map на соответствующий VLAN.

6. Посмотреть, а что же у нас получилось?

В данном примере мы определяем и накладываем VACL, который будет отбрасывать пакеты, попадающие в access list 1 из сети 192.168.1.0/24, при этом все остальные пакеты, попадающие в access list 2 будут переданы. VACL применяется к VLAN-ам с 5 по 10.

Switch(config)#access-list 1 permit 192.168.1.0 0.0.0.255

Switch(config)#access-list 2 permit any

Switch(config)#vlan access-map mymap 10

Switch(config-access-map)#match ip address 1

Switch(config-access-map)#action drop

Switch(config-access-map)#exit

Switch(config)#vlan access-map mymap 20

Switch(config-access-map)#match ip address 2

Switch(config-access-map)#action forward

Switch(config-access-map)#exit

Switch(config)# vlan filter mymap vlan-list 5-10

Switch(config-access-map)#end

Switch# show vlan access-map

Vlan access-map «mymap» 10

Match clauses:

ip address: 1

Action:

drop

Vlan access-map «mymap» 20

Match clauses:

ip address: 2

Action:

Forward

Switch# show vlan filter

VLAN Map mymap is filtering VLANs:

5-10

MAC ACL

MAC ACL, также известный как Ethernet ACL предназначен для фильтрации non-IP трафика на VLAN или физических интерфейсах Layer 2 используя MAC адреса в именованном расширенном MAC extended ACL.

Шаги по конфигурации MAC ACL подобны обычным именованным расширенным ACL. MAC ACL могут применяться только для фильтрации входящего трафика.

Для определения MAC Extended ACL используется команда mac access-list extended.

После того, как MAC ACL будет создан, его необходимо наложить на интерфейс Layer 2 используя команду mac access-group [acl-name] in

В примере ниже мы покажем, как создать и применить MAC ACL для блокировки всех пакетов AppleTalk Address Resolution Protocol (AARP), пропуская отсальной трафик

Switch(config)# mac access-list extended my-mac-acl

Switch(config-ext-macl)# deny any any aarp

Switch(config-ext-macl)# permit any any

Switch(config-ext-macl)# exit

Switch(config)# interface Fastethernet0/10

Switch(config-if)# mac access-group my-mac-acl in

Switch(config-if)# end

Switch#

Оригинал: http://dreamcatcher.ru/cisco/003_switches.html

Ссылки:

Отправить на почту

Отправить на почту

(голосов: 3, среднее: 4,00 из 5)

(голосов: 3, среднее: 4,00 из 5)

(голосов: 2, среднее: 4,50 из 5)

(голосов: 2, среднее: 4,50 из 5)